概要

説明

トピックス

- QE for Capacitive Touch は、新製品 RL78/F25, RL78/L23 に対応しています。

- QE for Capacitive Touch は、新製品 RA0L1 に対応しています。

- 自動チューニングで決定するセンサドライブパルス周波数の改善(CTSU2)

- ワークフローにエミュレータ/シリアルの選択ステップを追加

以下のツールニュースの注意事項を改修しました。

【注意事項】e² studio 2025-07とReality AI Utilities, AI Navigator, QE for Capacitive Touch, QE for AFEおよび他QE製品の非互換性について (PDF | English, 日本語)

- QE for Capacitive Touch は、新製品 RL78/F25, RL78/L23 に対応しています。

- QE for Capacitive Touch は、新製品 RA0L1 に対応しています。

- 自動チューニングで決定するセンサドライブパルス周波数の改善(CTSU2)

- ワークフローにエミュレータ/シリアルの選択ステップを追加

以下のツールニュースの注意事項を改修しました。

【注意事項】e² studio 2025-07とReality AI Utilities, AI Navigator, QE for Capacitive Touch, QE for AFEおよび他QE製品の非互換性について (PDF | English, 日本語)

静電容量タッチキーを使用した組み込みシステム開発に必要なタッチインタフェースの初期設定や感度調整に対応した開発支援ツールです。

本製品は、無償で提供します。

特長

- GUIで初心者でもタッチインタフェースの開発を簡単に

- タッチセンサ感度の自動チューニング

- Learn More

リリース情報

| 製品名 | 最新Ver. | リリース日 | ターゲットデバイス (Note1) | バージョンアップ内容 | ダウンロード | 動作環境 |

|---|---|---|---|---|---|---|

| QE for Capacitive Touch | V4.2.0 | 2025/08/01 | RAファミリ RL78ファミリ RXファミリ Renesas SynergyTM | リリースノート参照 | ダウンロード | e² studioプラグイン(Note2)(Note3) 動作環境 |

Note

- 詳細なサポートデバイスは「ターゲットデバイス」をご参照ください。

- RAファミリをご利用の方はRAファミリ向けe² studioインストーラのご使用をおすすめします。詳細はFlexible Software Package (FSP)のGitHub ページをご参照ください。

- Renesas SynergyTM向けには SSP(Synergy Software Package)が含まれているプラットフォームインストーラでインストールすることをお勧めします。

詳細はこちら

ターゲットデバイス

設計・開発

調べる

サポート

ビデオ&トレーニング

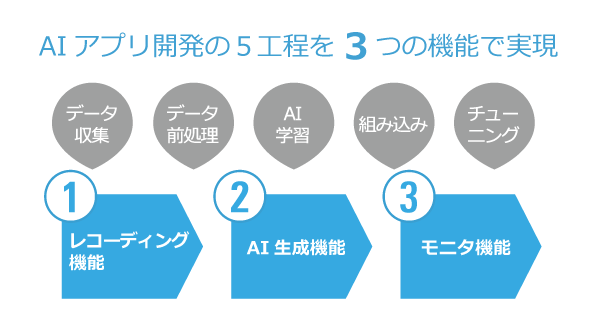

ルネサスの静電容量式タッチセンサ対応開発ツールQE for Capacitive Touchは、GUI上でガイドに従い操作するだけでタッチセンサの開発が可能で、静電容量センサユニット(CTSU2)の性能を活かしたタッチセンサ機能の開発期間短縮に貢献します。

関連リソース

ニュース&ブログ

ブログ

2023年11月21日

|

ブログ

2022年5月17日

|

詳細情報

機能

GUIで初心者でもタッチインタフェースの開発を簡単に

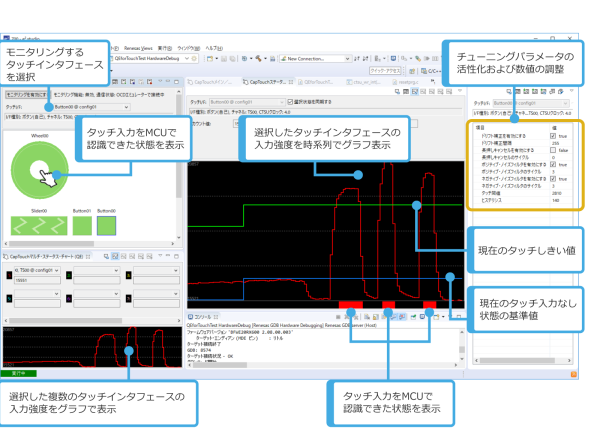

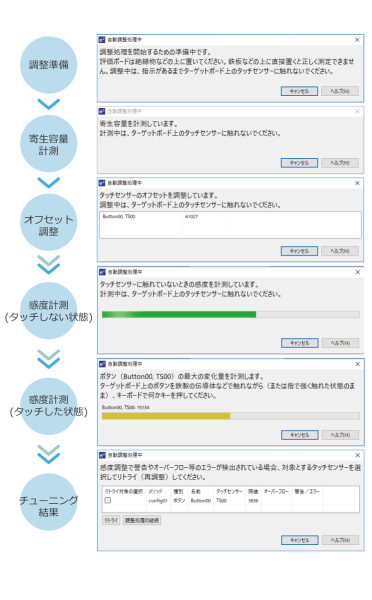

初心者でも簡単なGUI操作でタッチインタフェース構成の作成、タッチ入力状態のモニタリング、パラメータ調整が可能です。また、リアルタイムでチューニングパラメータを調整、反映し、その結果をすぐ表示できるため、静電気が多い状態や手が濡れた状態など、様々なケースで最適なパラメータを探すことに役立ちます。

サポートドライバとミドルウェア

| デバイス | ドライバ | バージョン |

|---|---|---|

| RAファミリ | CSTU (Capacitive Touch Sensing Unit) Driver RAファミリ用 Flexible Software Package (FSP) コンポーネント コンポーネント名: r_ctsu | V6.0.0 |

| Touch Middleware RAファミリ用 Flexible Software Package (FSP) コンポーネント コンポーネント名: rm_touch | V6.0.0 | |

| RXファミリ | CTSU用ドライバ RX Family QE CTSU Module Using Firmware Integration Technology モジュール名: r_ctsu_qe | V3.20 |

| タッチ用ミドルウェア RX Family QE Touch Module Using Firmware Integration Technology モジュール名: rm_touch_qe | V3.20 | |

| RL78ファミリ | CTSU用ドライバ RL78 Family QE CTSU Module Software Integration System モジュール名: r_ctsu | V2.20 |

| タッチ用ミドルウェア RL78 Family QE Touch Module Software Integration System モジュール名: rm_touch | V2.20 | |

| Renesas Synergy | CTSU (Capacitive Touch Sensing Unit) Driver Synergy Software Package (SSP) コンポーネント コンポーネント名: r_ctsuv2 | V2.6.0 |

| Capacitive Touch Framework Synergy Software Package (SSP) コンポーネント コンポーネント名: sf_touch_ctsuv2 | V2.6.0 |

QE for Capacitive Touch関連のミドルウェア追加と設定の詳細はこちら

動作確認済みデバッグツール

| デバイス | E2エミュレータ | E2エミュレータLite | J-link |

|---|---|---|---|

| RAファミリ | ✔ | ✔ | ✔ |

| RXファミリ | ✔ | ✔ | ✔ |

| RL78ファミリ | ✔ | ✔ | |

| Renesas Synergy | ✔ |