振り返り:AIの進化

AIは1950年代に存在しており、研究者たちが「考える」ことができる機械を初めて想像した時代からです。 初期のAIシステムは、あらかじめ定義されたルールに従う固定的で柔軟性のない仕組みでした。しかし、機械学習やディープラーニングの台頭により、AIは大きな変革を遂げました。今では、AIはデータから学び、時間とともに改善を続ける適応型のテクノロジーへと進化しています。 2010年代になると、AIは私たちの生活に欠かせないテクノロジーを支えるようになりました。音声アシスタント、レコメンデーションエンジン、そして自動運転車に至るまで、AIは幅広い分野で活用され、革新を加速させています。 しかしAIが成熟するにつれ、集中型クラウドコンピューティングだけに依存することには限界があることが明らかになりました。特に、リアルタイム応答性、強固なプライバシー保護、そして低消費電力を求めるアプリケーションにおいて、その課題は顕著です。

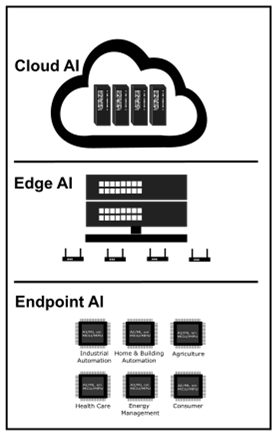

この流れは、AIの進化における自然なステップでした。

- クラウドAI は、集中型のインテリジェンスを提供し、強力なツールを幅広く利用可能にしました。

- エッジAI は、処理をデータソースに近づけることで、レイテンシを低減し、プライバシーを強化しました。

- エンドポイントAI は、超効率的なインテリジェンスを小型デバイスに直接搭載し、分散型AIを実現しました。

各フェーズの進化は、より高速で、よりスマートに、そしてより正確で安全な応答への高まるニーズを反映していました。その背景には、過去の経験から得られた教訓と、現代テクノロジーの進化による要求の変化があります。

クラウドAI:非常に高性能だが万能ではない

近年、クラウドAIプラットフォームは、私たちの人工知能との関わり方を一変させました。 代表的なツールには次のようなものがあります:

- OpenAIのChatGPT: テキスト生成、質問への回答、コード作成、アイデアのブレインストーミングを簡単に実現。

- Google Gemini: テキスト、画像など複数のモードを理解・生成できるマルチモーダル機能で可能性を拡大。

- Microsoft Azure AI: 開発者や企業が高度な機械学習モデルを大規模に構築・学習・展開できる環境を提供。

- Amazon SageMaker: 機械学習モデルの開発から学習、デプロイまでを包括的にサポートするエンドツーエンドプラットフォーム。

これらのプラットフォームは、コンテンツ生成、データ分析、カスタマーサポートの自動化、企業の意思決定支援に優れています。 さらに、迅速なプロトタイピングにも最適で、チームが短期間でテストと改善を繰り返すことを可能にします。

しかし、クラウドAIには多くの強みがありますが、万能な解決策ではありません。 安定したインターネット接続に依存し、リアルタイム応答が求められる自動運転や産業制御などの重要なタスクには不向きです。 データがリモートで処理されるため、オフライン機能は制限され、レイテンシの問題や、機密情報がデバイス外に出ることで生じるプライバシー懸念もあります。 さらに、クラウドAIは省電力性が重要な環境には最適化されていません。 こうした制約が、エッジAIとエンドポイントAIという次世代技術の登場を後押ししました。 データをローカルで処理することで、高速な応答、強固なプライバシー保護、そして高い自律性を実現します。特に、クラウド接続が困難または安全でない状況で、その価値は際立ちます。

エッジAI:よりスマートに、より高速に、そしてローカルに接続

エッジAIは、データが生成される場所にインテリジェンスを近づけます。カメラ、車、産業機械といったデバイス上で、クラウドにすべてを送信する代わりに、ローカルでデータを処理します。 処理はデバイス上、または近隣のサーバーやゲートウェイで行われるため、レイテンシを大幅に低減し、リアルタイム性を確保できます。

特に、自動運転、産業オートメーション、ライブ動画解析といったアプリケーションでは、リアルタイムの意思決定 が不可欠です。 データがクラウドに送られて戻るのを待つだけでは、スピードが足りません。 エッジAIは、この課題を解決します。データの発生源で直接処理することで、即時応答を実現するのです。

また、プライバシー保護とネットワーク効率においても大きなメリットをもたらします。 データがローカルで処理されるため、クラウドへの送信が不要になり、情報漏えいのリスクを低減し、ネットワークリソースを節約できます。 さらに、デバイスはオフラインでも機能を継続できるため、遠隔地や接続が不安定な環境では不可欠なソリューションです。

しかし、すべてのデバイスが複雑なAIモデルを単独で実行できるわけではありません。 そこで登場するのがローカルサーバー(エッジゲートウェイ)です。 これらは近隣のハブとして機能し、より重い処理を担当し、レイテンシを低減します。さらに、複数のデバイスが効率的に連携し、リソースを共有できる環境を提供します。

それでも、エッジAIにも独自の課題があります。 クラウドに比べてローカルの計算能力は制限されるため、モデルの複雑さに制約があります。 分散型ネットワークの管理は複雑で、メンテナンスや定期的なアップデートが必要です。 セキュリティもまた懸念事項です。ローカルシステムは脆弱性を回避するため、十分な保護が必要です。 さらに、データが多数のデバイスに分散することで、集約が難しくなり、断片化のリスクが生じます。

それでもなお、エッジAIは急速に普及しています。なぜなら、クラウドでは実現できない スピード、自律性、そして制御性を、必要な場所で提供できるからです。

エンドポイントAI:小さなデバイスに大きなインテリジェンス

エンドポイントAIは、AIの進化をさらに一歩進めます。マイクロコントローラや組み込みシステムといった超小型・低消費電力デバイス上でAIを実行することで、データを収集するだけでなく、その場で分析し、即座にアクションを取ることが可能になります。

エンドポイントAIに求められる重要要件

現代の多くのアプリケーション、例えば遠隔地の工業現場からエッジ型の医療システムまで、デバイスは電力制約のある環境で動作する必要があります。つまり、限られた電力条件下で効率的に動作し、1ワット単位での最適化が求められるのです。 過酷な環境に設置されたセンサーや、モバイルシステム内の制御ユニットなど、課題は共通しています:スマートな機能を提供しながら、リソースを消耗しないこと。

この要求に応えるためには、エネルギー効率が極めて重要です。AIモデルは、信頼性を維持しながら、最小限の電力で動作する必要があります。 そのためには、設計の再考が不可欠です。コンパクトで効率的なモデルを採用し、限られたメモリや計算リソースを持つデバイス上でアルゴリズムがスムーズに動作するようにすることが求められます。

エンドポイントAIでは、堅牢なセキュリティも最優先事項です。 特に医療や産業分野のように機密情報を扱う場合、データはローカルで保護される必要があります。 クラウド接続に依存することは、常に安全であるとは限りません。

さらに、信頼性の高いパフォーマンス も欠かせません。 外部ネットワークやクラウドサービスが利用できない、あるいは不安定な環境でも、デバイスは一貫して自律的に機能しなければなりません。

これらの要件――電力制約下での動作、エネルギー効率、コンパクトで効率的なモデル、堅牢なセキュリティ、そして信頼性――は、電力制約環境におけるインテリジェントシステムの基盤を形成し、その結果、効率性・安全性・自律性を兼ね備えた次世代ソリューションが実現します。

エンドポイントAIの課題

エンドポイントAIへの移行には、いくつかの課題があります。

多くのエンドポイントデバイスは厳しいハードウェア制約の下で動作しており、処理能力やメモリが限られているため、従来のAIモデルをそのまま実行することは困難です。 この課題を克服するためには、モデルの圧縮や簡素化による最適化が不可欠です。 ただし、精度を犠牲にせずに効率化することは、パフォーマンスと省リソースの微妙なバランスを求められます。

さらに、こうしたモデルを数百万台規模のデバイスに展開・管理することは、別の複雑さを伴います。 特に、デバイスが地理的に分散し、多様な環境に設置されている場合、デプロイやアップデートの運用負荷は非常に高くなります。 相互運用性 も欠かせない要件です。デバイスは、メーカーやプロトコルに関係なく、より広範なシステムやネットワークとシームレスに統合される必要があります。

こうした課題にもかかわらず、エンドポイントAIはインテリジェントコンピューティングの次なるフロンティアとして急速に台頭しています。 クラウド応答を待つ必要がなく、デバイス上で リアルタイムの意思決定が可能 にすることで、スピードと応答性を飛躍的に向上させます。 さらに、分散型AIエコシステムを構築し、インテリジェンスを集中型から分散型へと進化させる ことができます。

最も重要なのは、エンドポイントAIがデータをローカルに保つことで プライバシーと自律 性を高めていることです。 これは、ヘルスケア、製造業、スマートインフラなど、セキュリティが重要な業界において特に価値があります。

ルネサスが実現するエンドポイントAI

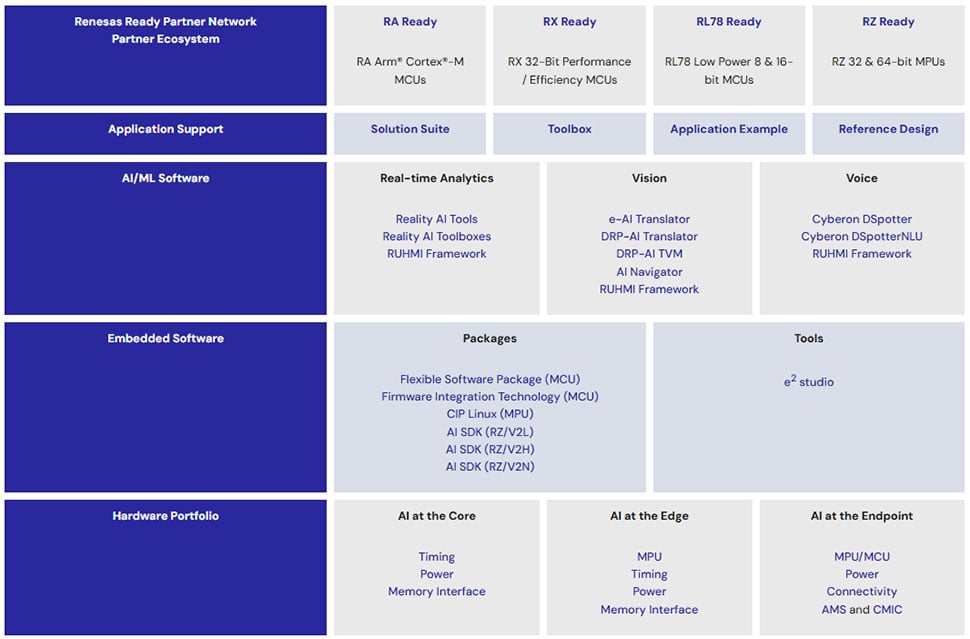

ルネサスは、エンドポイントAIの課題に対応するため、シリコンからソフトウェアまでを包括する堅牢でスケーラブルなソリューションスタックを提供しています。

このスタックは、インテリジェントで接続されたAIoTシステムを構築するための完全な環境を実現します。 まずは、低消費電力センサーから高性能エッジ処理まで、あらゆるものをサポートする堅牢なMCUおよびMPUのハードウェアポートフォリオから始まります。 このハードウェアの上には、組み込みソフトウェア、ソフトウェア開発キット(SDK)、e² studio IDEのようなツールがシームレスな統合を可能にします。 次の層では、Reality AI Tools® やRobust Unified Heterogeneous Model Integration(RUHMI)などのAI/MLソフトウェアレイヤーがリアルタイム分析、画像認識、音声処理を可能にします。 アプリケーションサポートでは厳選されたリソースで開発を加速し、信頼性を確保するパートナーエコシステムパートナーエコシステムも活用しながら、シリコンからインテリジェントへの円滑な開発の旅を支援します。

次に、このソリューションスタックにおけるプロセッサとソフトウェアレイヤーの詳細をご紹介します。柔軟性とパフォーマンスをもたらすこの層は、多様なAIoTアプリケーションに対応しています。

ハードウェアラインナップ – 超低消費電力MCUから高性能MPUまで

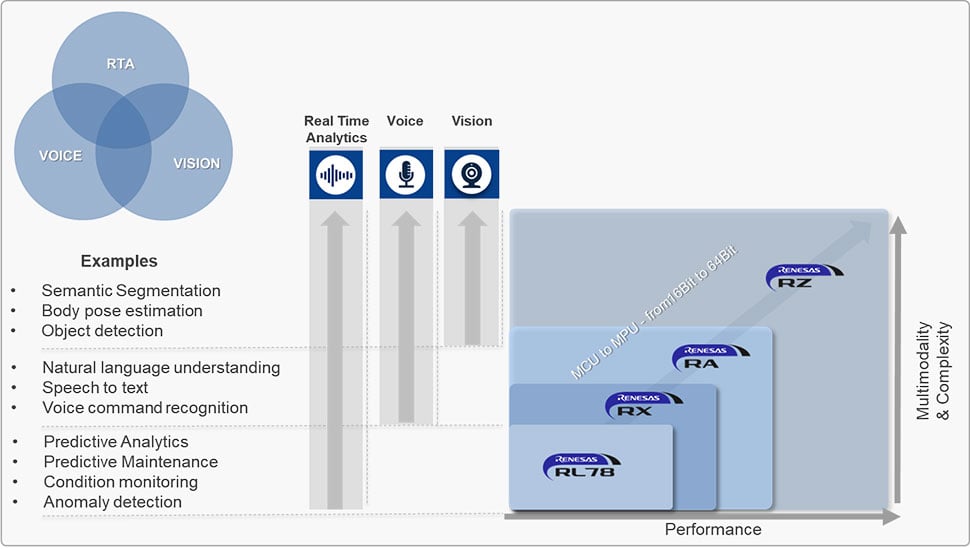

ルネサスは、進化するAI/MLのニーズに対応するため、16ビット・32ビットMCUから64ビットMPUまでのスケーラブルなポートフォリオを提供しています。これにより、シンプルなセンシングから複雑なマルチモーダル処理まで幅広いアプリケーションをカバーします。

- RL78: 超低消費電力で、単機能のシンプルなAIタスクに最適

- RX: 基本的なマルチモーダルAIに対応する効率的なパフォーマンス。

- RA: 音声・画像・分析など高度なAI処理に必要な高い演算性能

- RZ: 複雑なリアルタイム・マルチモーダルAIに対応可能な最大処理能力

このラインアップにより、開発者はアプリケーションが求めるAI/ML要件に応じて計算リソースを最適化し、シンプルな分析から完全統合型のインテリジェントエッジソリューションまでスケールすることが可能です。

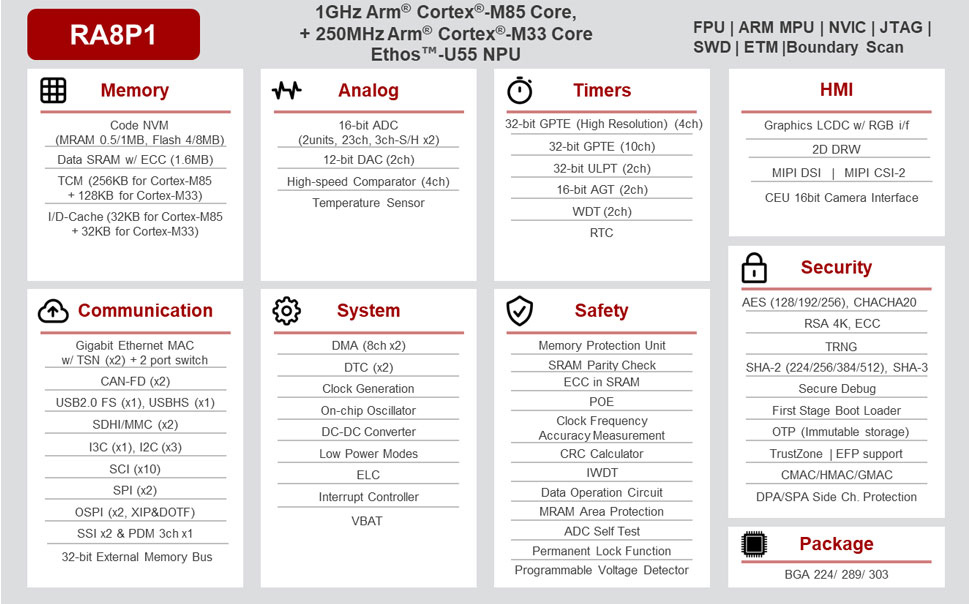

Ethos™搭載ハードウェア - U55ニューラルプロセッシングユニット

ルネサス初の32ビットAIアクセラレーションMCUである RA8P1 グループは、Arm® Cortex-M85®コア、大容量オンチップメモリ、高度な周辺機器、外部メモリインターフェースを搭載し、計算集約型のAIワークロードに最適です。 シングルコアとデュアルコアの両方のバリエーションを提供し、スケーラビリティと堅牢なセキュリティ機能を実現。暗号化IP、イミュータブルストレージ、タンパー検出などの機能により、安全性と信頼性を確保します。 開発は、Flexible Software Package(FSP)、RUHMI AIプラットフォーム、そしてe² studio IDEによって効率化されます。これにより、開発者はスムーズなワークフローを実現できます。

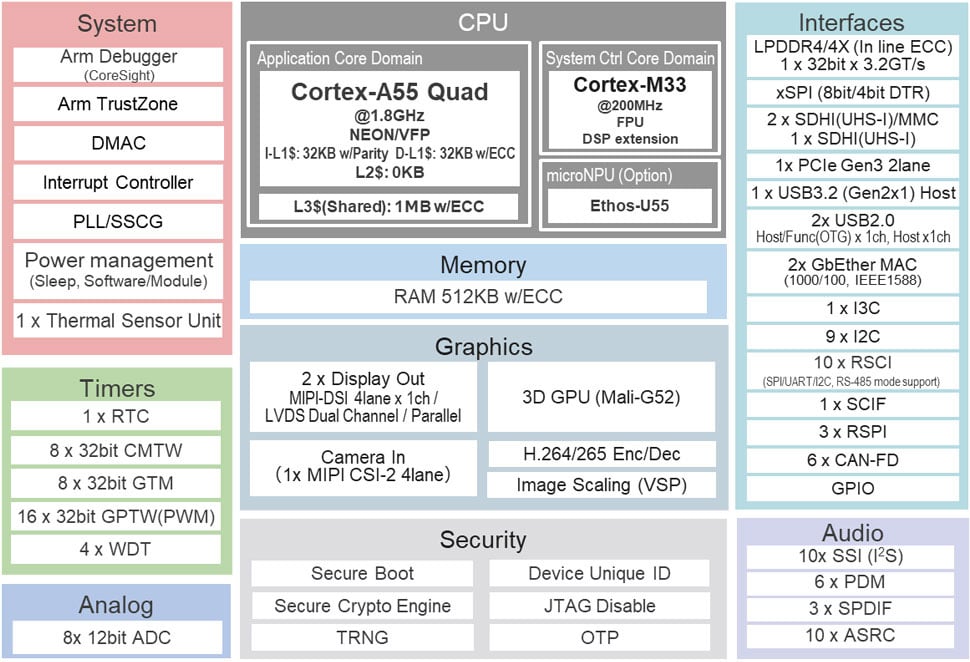

エッジAI向けに設計された RZ/G3E マイクロプロセッサは、クアッドコアのArm Cortex-A55とCortex-M33を組み合わせ、高度なAI推論のための統合NPUを備えています。 Mali-G52 GPU、ビデオコーデック、マルチスクリーンフルHD出力、さらにLPDDR4/4XメモリやPCIe Gen3やギガビットイーサネットなどの高速インターフェースを備えたリッチなヒューマンマシンインターフェース(HMI)アプリケーションをサポートしています。 さらに、暗号化エンジンやタンパー(改ざん)プロテクションを内蔵し、セキュアで高性能なエッジコンピューティングを実現します。

ソフトウェアとツール

ルネサスのインテリジェントツールとフレームワークで、設計から導入までAIイノベーションを加速させましょう。

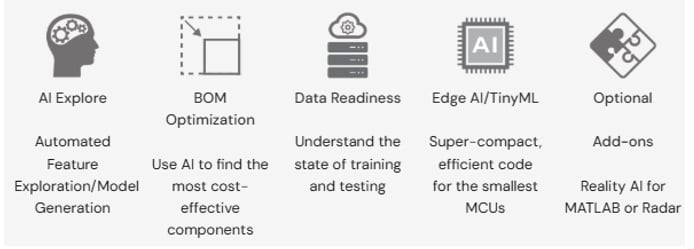

Reality AI ToolsとUtilities

高速で効率的なTinyMLやエッジAIモデルを構築するためのスマートな統合プラットフォーム。 高度な信号処理と自動データ探索を活用し、最適なセンサーや配置の特定、さらには部品仕様の生成まで、統一されたワークフローで開発者を支援します。

モデルは時間領域と周波数領域の両方で完全に説明可能であり、最適化されたコードを出力します:

- Arm Cortex-M、A、R

- ルネサス独自のRX、RL78コアーー これにより、データからデバイスへまで自信をもって展開が可能になります。 さらにReality AI Explorer Tierと組み合わせることで、開発者は実環境での実験、検証、加速を実現し、幅広いアプリケーションに対応します。

Reality AI™ Utilities

生のセンサーデータから、MCUやMPUなどのエッジデバイス上で動作するAIモデルまでの道のりをシンプルにします。 Renesas e² studioはもちろん、他のIDEでも、データ収集・モデル学習・検証・導入まで、AIワークフローをフルサポートします。 主な特徴:

- ルネサスベースのプロジェクトからリアルタイムのセンサーデータを取得するための組み込みツール

- Reality AI Toolsへの直接アップロード

- 最適化されたAIモジュールを返し、コードに統合できる準備を整えています

さらにFSP/FITも統合され、センサーデータのフローを抽象化。配管作業ではなく、構築に集中できます。

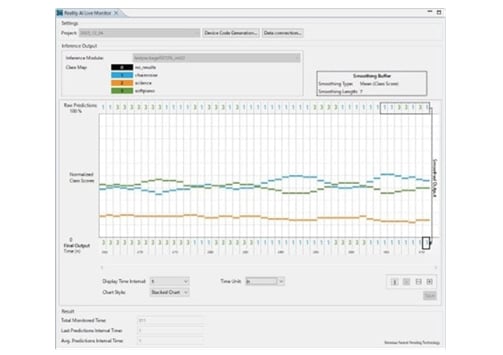

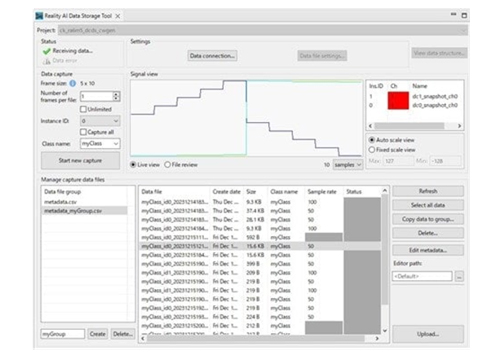

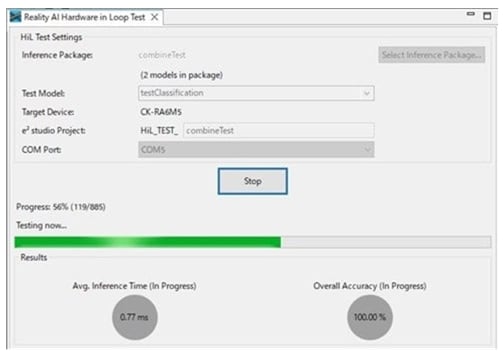

検証のために、HiL(Hardware in Loop) TestingとAI Live Monitorが実機上でのモデル性能をリアルタイムに可視化。デバッグやチューニングを容易にし、エッジAIへの信頼性を高めます。

図7. AI Live Monitor

図8. データ収集ツール

図9. HiLテスト

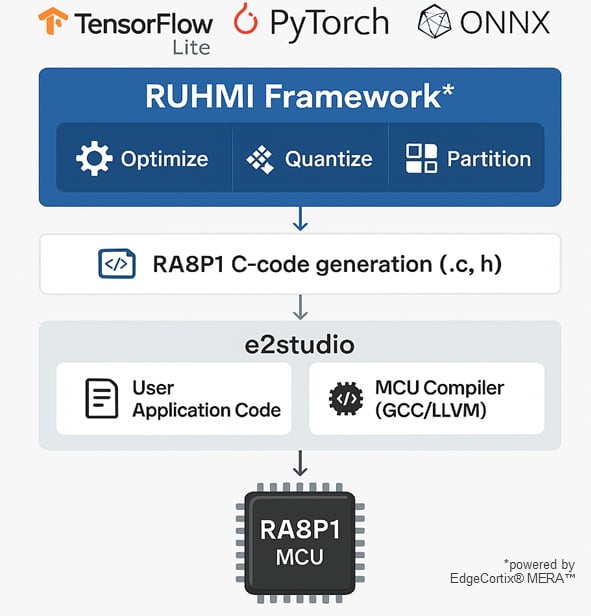

RUHMI フレームワーク (Robust Unified Heterogeneous Model Integration)

RUHMIフレームワークは、AIモデルから組み込み展開までのプロセスをシンプルに。開発を始めたばかりの方から本番最の適化まで、幅広く対応します。 Renesas e² studioに統合されているか、またはスタンドアロンツールとして利用可能なRUHMIは、強力なAIコンパイラを搭載し、ルネサスの組込みプロセッサ向けに高度に最適化されたコードをわずか数分で生成します。

TensorFlow Lite(TFL)、Pytorch、ONNXなどの人気フレームワークからのモデルインポートをサポートし、学習後のキャリブレーション、量子化、変換を自動的に処理します。 その結果、クリーンで効率的なC/C++コードの展開準備が整います。 さらにPython API、CLIおよびGUIオプション、最新のRA8P1 MCU向けを含むサンプルも用意されており、RUHMIはワークフローにシームレスに組み込まれています。

Renesas AI Model Deployer(RAIMD):Vision AIをもっと開発者フレンドリーに

Renesas AI Model Deployerは、Vision AI Model Zooのパワーを直感的でわかりやすいGUIに統合し、組込み開発者がエッジでVision AIモデルを構築・学習・デプロイする作業を簡単にします。

クラウド環境は不要。ローカルワークステーション上で動作し、ワークフローを完全にコントロールできます。 物体検出や画像分類に対応し、データセットから展開までわずか数クリックで完了。 プロジェクト設定、データセット解析、学習(QATやプルーニングを含む)、視覚的な評価、ハードウェアへの展開までを自動化しています。

ライブカメラインタフェース、USBストリーミング、リアルタイムフィードバックにより、モデルの検証を迅速かつ確実に行います。 さらに上級者向けには、GitHubで提供されているJupyterノートブックを活用すれば、データ拡張、ハイパーパラメータの調整、BYOM(Bring Your Own Model)ワークフローなど、より高度なカスタマイズも可能です。

開発プラットフォーム

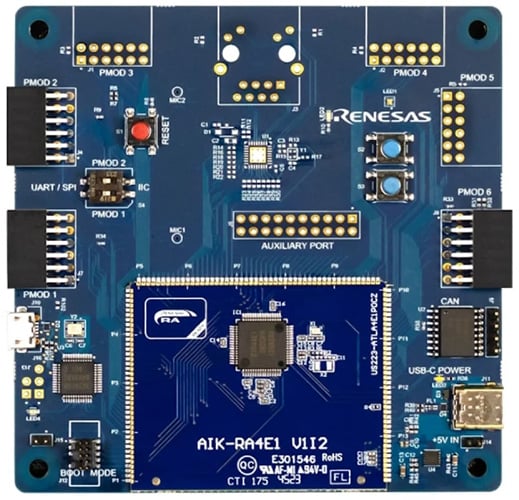

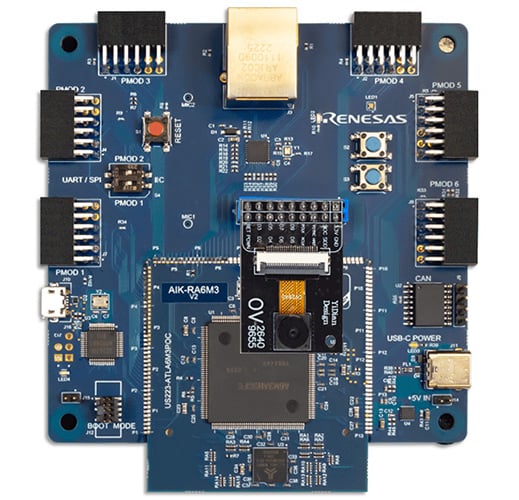

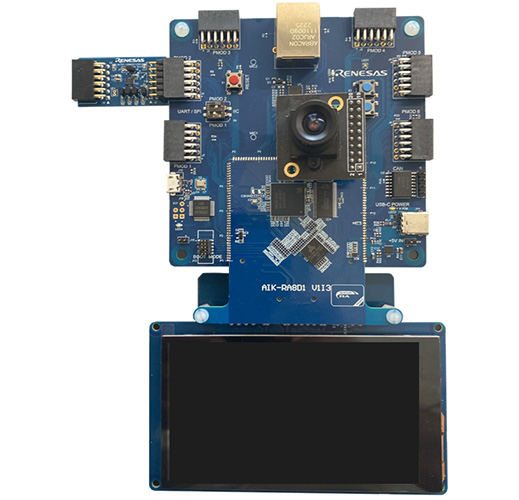

AIキット - AIKリファレンスボード

すべてのAIキットは、ビジョン、オーディオ、リアルタイム分析における柔軟なマルチモーダルAI/ML開発を可能にするよう設計されています。 特定のモデルに依存せず、迅速なプロトタイピングとイノベーションのための共通基盤を提供します。 AIK-RA8D1のようなボードは、ビジョン、オーディオ、リアルタイム分析を含むマルチモーダルに対応し、迅速なプロトタイピングを実現するために設計されています。 単なる開発ハードウェアではなく、イノベーションのための発進点として機能します。 再構成可能な接続性により、開発者はセンサーの追加、コンポーネントの交換、AI/MLシステムの再設計を容易に行え、固定的なアーキテクチャに縛られることはありません。

目的がビジョン認識、リアルタイム分析、オーディオ処理のいずれであっても、AIK-RA8D1は準備万端です。 内臓のアナログマイクやカメラとシームレスに統合し、シングルまたはマルチモーダルのAI/MLソリューションを簡単に構築できます。

さらに、Reality AIソフトウェアと組み合わせることで、実用的なリアルタイムインサイトを実現します。 Renesas Ready Partner Networkのサポートにより、開発者はビジョンやオーディオのユースケースに特化した豊富なツールやサンプルを活用できます。

既存のアプリケーション評価から新しいアプリケーションの開発まで、AIキットは単なるキットではなく、創造性を広げるキャンバスであり、組み込みインテリジェンスの未来へのゲートウェイです。

ソリューションスイート、アプリケーション例、ソリューションスイートコンセプト

イノベーションを加速するために、ルネサスはソリューションスイート(Solution Suites)、厳選されたアプリケーション例、リファレンスデザイン、AI/MLに対応したコンセプトのコレクションを提供しています。 これらは、ハードウェア、ソフトウェア、そして事前に統合されたインテリジェンスを組み合わせ、開発者がアイデアから実装へ自信を持って進められるよう支援します。

スマートHVACシステム、インテリジェントエッジデバイス、次世代の産業用ソリューションの構築など、どのようなプロジェクトでもSolution Suitesが開発のスタートダッシュを実現し、創造に集中できます。

さらに、ルネサスは豊富なパートナーエコシステム、オンデマンドトレーニング、リファレンスデザインを提供し、市場投入までの時間を短縮します。

AIは研究室から始まり、クラウドへと移行し、エッジで加速し、今や私たちの周りの最も小さなデバイスで動作しています。 その進化の過程で、AIは現実の課題を解決し、より応答性が高く、プライバシーに配慮し、アクセスしやすくなりました。 ルネサスが先導することで、エンドポイントAIはよりスマートに、スケーラブルに、そして簡単に導入できるようになり、ウェアラブルやロボティクスから産業機械まで、あらゆるものにインテリジェンスをもたらします。 リアルタイム分析、音声、ビジョンにわたるルネサスのEdge AIの進化をご覧ください。