e-AI Translator とは

オープンソースのAIフレームワークを用いて作成した学習済みAIアルゴリズムを推論専用のCソースコードに変換するツールです。 e-AI Translatorの最新版V2.1.0を2021年9月30日にリリースしました。 今回のブログでは、V2.1.0の新機能「“TensorFlow Lite”対応による8bit量子化機能」についてご紹介いたします。

MCUでAIを処理する際のボトルネック:メモリリソース

センサー類を接続したMCUで、データの取得だけではなく、AIアルゴリズムを利用した判定を行うニーズが増えてきました。判定にリアルタイム性能が求められる場合、MCUはAIの動作環境として最適なプラットフォームだといえます。 一方、MCU上でAIアルゴリズムを利用する上で障害となるのが、メモリリソースの問題です。 AIアルゴリズムは、大量の変数をもった多項式で表現されています。 そのため、従来のアルゴリズムに比べると、パラメータ数が多く、メモリリソースの少ないMCUでAIアルゴリズムを利用する際の障壁となっていました。 近年、このメモリリソース問題を緩和する方法として、TensorFlow LiteによるAIアルゴリズムの量子化が広まっています。

TensorFlow Lite 8bit量子化のROM/RAM使用量削減効果

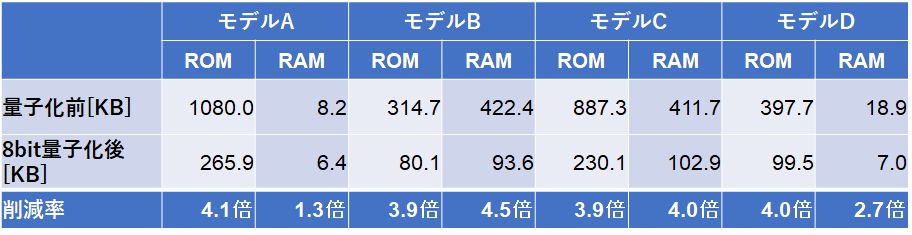

まず、TensorFlow Lite 8bit量子化によるMCUのROM/RAM使用量削減効果がどの程度なのかご確認ください。以下の通りモデルの構造によって削減効果は増減しますが、最大で4.5倍のROM/RAM削減効果があります。

8bit量子化の仕組みと推論精度への影響

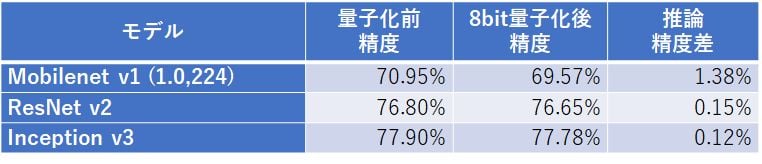

8bit量子化は、AIモデルで使用するパラメータや演算を32bit float形式から、より必要bit数の少ない8bit整数形式に変更することで、パラメータを格納するROM使用量や演算時に必要となるRAM使用量を削減することが可能となっています。 一方、bit数の削減によりパラメータや演算の表現力が低下する為、推論精度が下がることが懸念されます。では、実際にどの程度推論精度が低下するのかご確認ください。以下の通りモデル構造によって差はありますが、最も精度差が大きいMobileNet v1モデルでも、1%程度の推論精度の低下に収まっています。

https://medium.com/tensorflow/tensorflow-model-optimization-toolkit-post-training-integer-quantization-b4964a1ea9ba

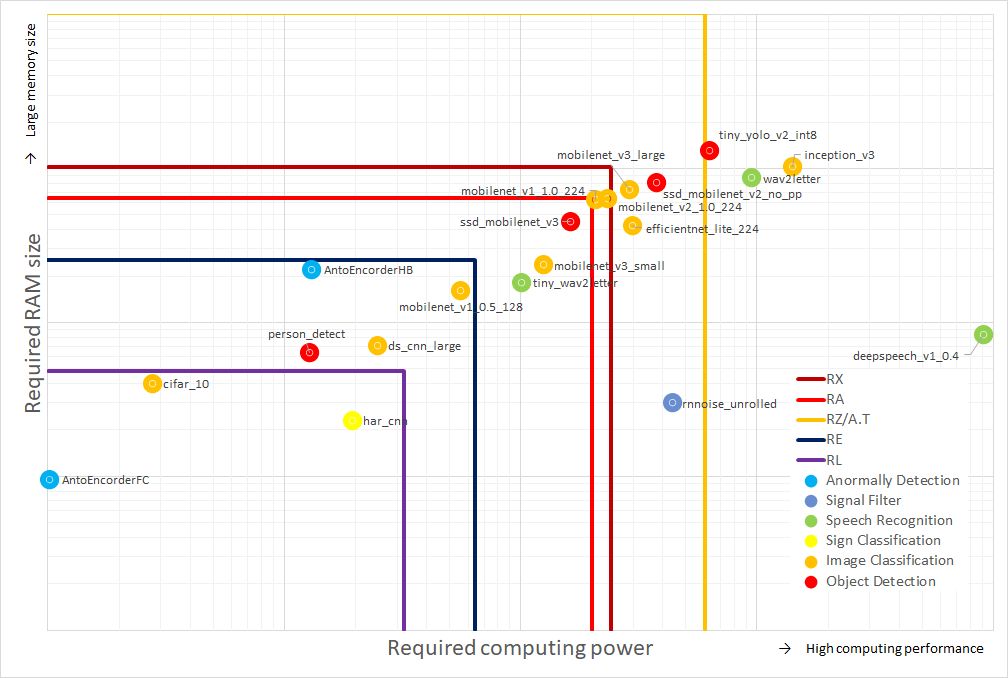

ROM/RAM使用量の削減効果が大きく精度低下度合いが少ない8bit量子化はMCUにとって理想的な機能と言えます。以下の図にあるように8bit量子化を使用することで様々なネットワークがMCU上で実行可能となります。是非ご活用ください。

ツールダウンロードリンク

アプリケーション > テクノロジー > e-AIソリューション > 開発環境 / ダウンロード

もしくは検索窓を使って、“e-AI”を検索、“開発環境 / ダウンロード”を選択してください

過去blog

MCU で AI を実現するツールe-AI Translator V2.0.0 リリース | Renesas